特斯拉FSD beta 來比眼力有沒有比AI好 - 特斯拉

By Michael

at 2021-04-09T03:48

at 2021-04-09T03:48

Table of Contents

※ 引述《ewings (火星人當研究生)》之銘言:

: ※ 引述《ykjiang (York)》之銘言:

: : 從最基本的原理來說,光達跟雷達就是用來測距,理論上只有一維的資訊

: : 三維的部分是經過一些設計、運算後得到的

: : 反而鏡頭得到的一開始就是二維資訊,然後可以經過運算得到三維的資訊,

: 這邊看完,我的感想只有“供三小?”

: 雷達與光達在原理上是利用掃描的方式,取得距離與向量,本質上資料的維度就是大於二維了。

: 是什麼時候變一維的?如果要這麼瞎扯,那鏡頭裡的CMOS一次也只能讀一個cell的資料,

: 一樣得要逐個掃描才能得到二維影像(這個就是所謂的果凍效應的成因),

: 照你的說法,鏡頭不也一樣是一維的?

雷達基本上是機械動作在掃描

初代的光達也一樣,最新的發展小型化後,有搞陣列方式同時發射好幾組雷射,不過

解析度還是個問題

你講的 CMOS 果凍效應,不是 CMOS 的本質,而是數位化後,要將資料放在記憶體,

從記憶體讀取時有先後順序,這基本上是電子式的掃描,跟前面的機械式有差距。

: : 特斯拉更進一步從中取得四維資訊(多的那維是時間軌跡預測)

: 這邊也不知道在供三小

: 在半個世紀前,雷達後處理技術就已經發展出利用比對前後時間目標的變化,預測目標未來位置,

: 並且持續追蹤的技術。甚至還有類似合成孔徑雷達(SAR)那種利用時間與位移積分,

: 利用二維掃描形成3維雷達影像的技術。

: 而利用都卜勒濾波技術,甚至不需要比對前後時間的資料,就能直接得到目標的速度,

: 在半個世紀前,雷達就能直接利用都卜勒測速,外插推估目標的未來位置。

: 但也沒人講雷達是四維資料的探測器。

你可以搜尋一下,有人就說這個是 4D 雷達

: 而特斯拉的前鏡頭並沒有構成立體視覺,就算加上時間預測,也只能構成2.5D,

去年 10 推出的 FSD Beta 8.1 跟今年三月的 FSD Beta 8.2 已經有立體視覺

預計四月(如果沒延期的話)推出的 FSD Beta 9 會是 Musk 說的 4D 視覺

: (三個定焦鏡只能利用影像模糊的程度大致判斷距離),這也是特斯拉自動駕駛在視覺深度一直為人所詬病的地方。

: : 以目前的技術:

: : 距離方面,光達的精度比較高

: : 平面部分,鏡頭的精度較高,然後鏡頭還可以判斷顏色這個重要資訊

: : 以自動駕駛而言,兩者的精度都超過人眼了

: : 所以關鍵還是在 AI 等其他方面

: 無腦特粉才會覺得只靠鏡頭和AI就行

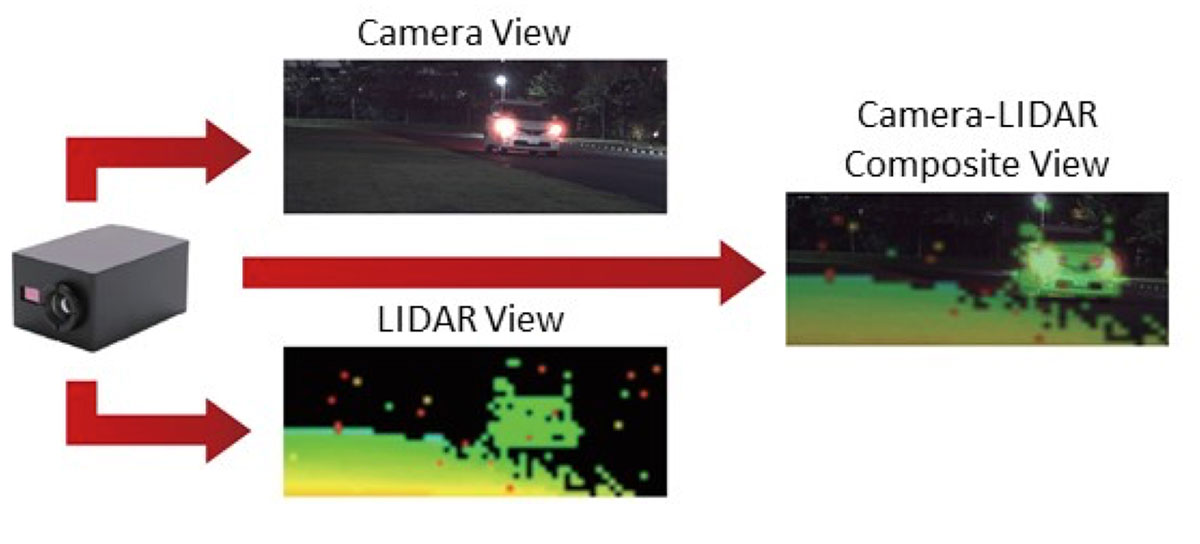

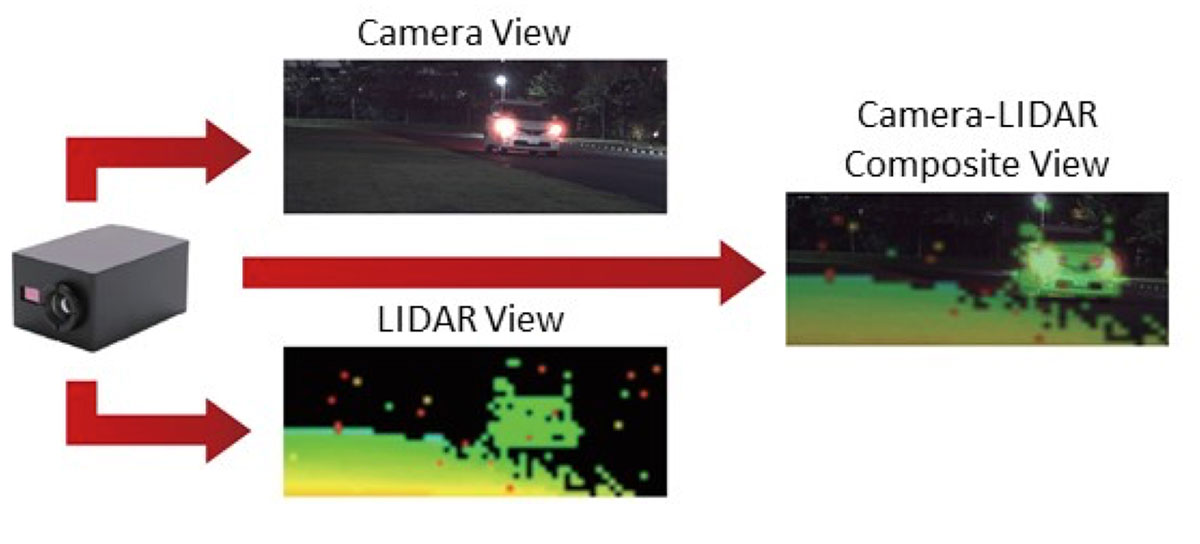

: 真的在搞自動駕駛的,在研究的是怎麼做多感測器的融合。

: https://global.kyocera.com/ces/img/sensing-technology/sec11_img03.jpg

: 像是直接將光達和攝影機做成同一個感測器,就是其中一個方向。

: 像是直接將光達和攝影機做成同一個感測器,就是其中一個方向。

就算如後面推文你說的,特斯拉前向三個鏡頭是不同測交距離的鏡頭,搞不出立體視覺

但你忽略了特斯拉側前方還有兩個前向鏡頭,是完全對稱的測焦距離是一樣的80M以內

--

: ※ 引述《ykjiang (York)》之銘言:

: : 從最基本的原理來說,光達跟雷達就是用來測距,理論上只有一維的資訊

: : 三維的部分是經過一些設計、運算後得到的

: : 反而鏡頭得到的一開始就是二維資訊,然後可以經過運算得到三維的資訊,

: 這邊看完,我的感想只有“供三小?”

: 雷達與光達在原理上是利用掃描的方式,取得距離與向量,本質上資料的維度就是大於二維了。

: 是什麼時候變一維的?如果要這麼瞎扯,那鏡頭裡的CMOS一次也只能讀一個cell的資料,

: 一樣得要逐個掃描才能得到二維影像(這個就是所謂的果凍效應的成因),

: 照你的說法,鏡頭不也一樣是一維的?

雷達基本上是機械動作在掃描

初代的光達也一樣,最新的發展小型化後,有搞陣列方式同時發射好幾組雷射,不過

解析度還是個問題

你講的 CMOS 果凍效應,不是 CMOS 的本質,而是數位化後,要將資料放在記憶體,

從記憶體讀取時有先後順序,這基本上是電子式的掃描,跟前面的機械式有差距。

: : 特斯拉更進一步從中取得四維資訊(多的那維是時間軌跡預測)

: 這邊也不知道在供三小

: 在半個世紀前,雷達後處理技術就已經發展出利用比對前後時間目標的變化,預測目標未來位置,

: 並且持續追蹤的技術。甚至還有類似合成孔徑雷達(SAR)那種利用時間與位移積分,

: 利用二維掃描形成3維雷達影像的技術。

: 而利用都卜勒濾波技術,甚至不需要比對前後時間的資料,就能直接得到目標的速度,

: 在半個世紀前,雷達就能直接利用都卜勒測速,外插推估目標的未來位置。

: 但也沒人講雷達是四維資料的探測器。

你可以搜尋一下,有人就說這個是 4D 雷達

: 而特斯拉的前鏡頭並沒有構成立體視覺,就算加上時間預測,也只能構成2.5D,

去年 10 推出的 FSD Beta 8.1 跟今年三月的 FSD Beta 8.2 已經有立體視覺

預計四月(如果沒延期的話)推出的 FSD Beta 9 會是 Musk 說的 4D 視覺

: (三個定焦鏡只能利用影像模糊的程度大致判斷距離),這也是特斯拉自動駕駛在視覺深度一直為人所詬病的地方。

: : 以目前的技術:

: : 距離方面,光達的精度比較高

: : 平面部分,鏡頭的精度較高,然後鏡頭還可以判斷顏色這個重要資訊

: : 以自動駕駛而言,兩者的精度都超過人眼了

: : 所以關鍵還是在 AI 等其他方面

: 無腦特粉才會覺得只靠鏡頭和AI就行

: 真的在搞自動駕駛的,在研究的是怎麼做多感測器的融合。

: https://global.kyocera.com/ces/img/sensing-technology/sec11_img03.jpg

就算如後面推文你說的,特斯拉前向三個鏡頭是不同測交距離的鏡頭,搞不出立體視覺

但你忽略了特斯拉側前方還有兩個前向鏡頭,是完全對稱的測焦距離是一樣的80M以內

--

Tags:

特斯拉

All Comments

By Dorothy

at 2021-04-09T06:10

at 2021-04-09T06:10

By Sarah

at 2021-04-10T12:47

at 2021-04-10T12:47

By Elizabeth

at 2021-04-13T21:56

at 2021-04-13T21:56

By Leila

at 2021-04-14T05:58

at 2021-04-14T05:58

By Lily

at 2021-04-17T04:39

at 2021-04-17T04:39

By Gilbert

at 2021-04-19T07:48

at 2021-04-19T07:48

By Cara

at 2021-04-23T22:44

at 2021-04-23T22:44

By Carolina Franco

at 2021-04-27T12:34

at 2021-04-27T12:34

By Queena

at 2021-04-27T22:44

at 2021-04-27T22:44

Related Posts

特斯拉FSD beta 來比眼力有沒有比AI好

By Valerie

at 2021-04-08T23:15

at 2021-04-08T23:15

特斯拉FSD beta 來比眼力有沒有比AI好

By Franklin

at 2021-04-08T22:54

at 2021-04-08T22:54

特斯拉FSD beta 來比眼力有沒有比AI好

By Lydia

at 2021-04-08T22:23

at 2021-04-08T22:23

特斯拉FSD beta 來比眼力有沒有比AI好

By Iris

at 2021-04-08T19:39

at 2021-04-08T19:39

Model3在挪威取得所有車種第一名

By Skylar DavisLinda

at 2021-04-08T13:23

at 2021-04-08T13:23